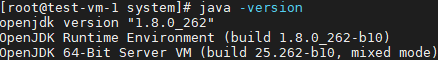

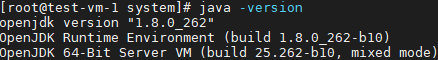

1. open jdk 설치(root권한상태) $ yum install java-1.8.0-openjdk-devel.x86_64 java -version으로 설치 확인 2. Scala 설치 (root권한상태) 2-1 scala 2.12.12 다운로드 $ wget https://downloads.lightbend.com/scala/2.12.12/scala-2.12.12.tgz 2-2 파일이동 $ mv scala-2.12.12.tgz /home/"사용할 계정"/ 2-3 압축해제 $ tar -xvzf scala-2.12.12.tgz 2-4 폴더명,권한 변경 $ cd /home/"사용할계정" $ mv scala-2.12.12.tgz scala $ chown -R "사용할계정":"사용할계정" scala 2-5 환경..